Коли класичні методи маніпуляцій чи розваг втратили актуальність, на арену вийшов плід нейромереж – deep fake. Звичайні фейки, які «лежали на поверхні» довели свою неефективність, адже наявність критичного мислення і знань факт-чекінгу спростовували їх на раз-два. А щодо розваг… Дивитись порно з незнайомцями – нудно, а от глянути на секс Бреда Піта з Джолі… Прийшов час заглибитись у mad world збочених технологій.

Дисклеймер: технології deep fake використовуються не лише для дискредитації та маніпуляцій, з їх допомогою можна створювати щось дійсно унікальне. Згадайте цьогорічне святкування Дня незалежності на НСК «Олімпійський», де Скрябін заспівав свою пісню, наче живий. Організатори «оживили» Кузьму за допомогою технологій нейромереж: тут ви можете побачити виступ голограми Скрябіна.

Що таке deep fake: коротко і ясно

Діп фейк – технологія на основі нейронних мереж, яка уможливлює перенесення характеристик (обличчя, голосу) одного об’єкта іншому: фотографії оживають, на відео з людиною «1» говорить чи рухається обличчя людини «2», синтезується голос (голосом людини можна сказати будь-що, що вона ніколи не говорила). Також це можна пояснити, як технологія синтезу зображення, заснована на штучному інтелекті та використовувана для заміни елементів зображення на бажані образи. Оригінальна людина чи її промова заміняється на фейкову з непомітністю такої підміни.

Де можна побачити deep fake

Що першим спадає на думку при слові фейк? У яких сферах його можна зустріти найчастіше? Звичайно ж, політика, медіа, розваги. Якщо ви знаєте більш несподівані сфери, де їх застосовують, пишіть в коментарях.

Перший глобальний «вихід у люди» діп фейк зробив у 2017. Тоді опублікували порнофільм, у якому обличчя героїні замінили на обличчя ізраїльської акторки Галь Гадот, що зіграла головну роль у фільмі «Wonder woman». З того часу ця технологія набирає обертів та активно використовується у сферах:

- Політика – маніпуляції під час виборчого процесу звична справа. Наразі ж можна робити це витонченіше. Медіа підхоплюють ці відео, розповсюджують їх, рідко перевіряючи справжність. Більшість людей вірять у те, що тільки здається правдою. Чому так відбувається? Бо ми не звикли до фейкових відео, наш мозок ще не готовий повірити в такі надсучасні технології. Однак, майбутнє вже тут. Перегляньте найпопулярніші приклади:

- Кіноіндустрія – deep fake дозволяє «воскресити» померлих акторів. До прикладу, в «Зоряних війнах» оживили Пітера Кушінга з оригінальної саги. Актор, котрий грає губернатора Таркіна, помер у1994 році. Його обличчя наклали на акторську гру британця Гая Хенрі.

- Розваги – будь-яка людина здатна створити свій діп фейк за допомогою спеціального ПЗ. Уявіть, що історичні постаті оживають, вони дихають, озираються і навіть говорять до нас. Тепер це може бути реальністю! Генеалогічний сайт MyHeritage представив новий сервіс під назвою DeepNostalgia.

- Віртуальна чи доповнена реальність – окремий тип розваг, що стрімко набирає популярності та стає доступнішим. Для створення цифрових двійників в іграх використовують такі ж технології. Це підвищує емоційне залучення.

Як працює технологія deep fake

Deep fake створили на основі генеративно-змагальної нейромережі (GAN). Одна частина алгоритму «вчиться» на реальних фотографіях певного об’єкта і створює зображення, «змагаючись» з іншою частиною алгоритму, поки та не почне плутати копію з оригіналом. Тобто одна створює, інше виявляє і так до нескінченності, до ідеальної підробки. Існує три найпопулярніших різновидів діп фейків:

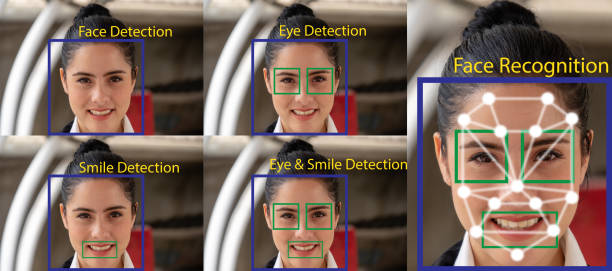

- Заміна обличчя – у відео обличчя актора підміняється обличчям іншої людини. Його застосовують для вставки голів відомих акторів у фільми, в яких вони ніколи не з’являлися.

- Синхронізація губ – вихідне відео модифікують так, що область рота узгоджується з неоригінальним, іншим аудіозаписом. На фейковому відео людина може говорити зовсім не те, що в оригіналі, виглядаючи при цьому відносно природно.

- «Ляльковик» – зображення людини (рухи головою та очима, жести, міміка) анімує виконавець, котрий сидить перед камерою і виконує дії, які він хоче бачити на відео від «ляльки».

Принцип роботи відносно простий: нейромережі дається великий масив даних ➡️ вона обробляє масив та вивчає особливості особи та її міміки ➡️ нейромережа вчиться відтворювати обличчя людини ➡️ а вже далі йде синтез фейкового контенту.

Чи існує антидот

Ситуація з діп фейками – складна. До Конгресу США подали відповідний законопроєкт Malicious Deep Fake Prohibition Act, у якому deep fake визначається як аудіовізуальний запис, створений або змінений таким чином, що спостерігач його може вважати автентичним. Важливим моментом є те, що у законопроєкті криміналізується використання глибинних підробок з метою шахрайства чи в порно. Якщо діп фейк створено для розваг, то згідно з Першою поправкою до Конституції США (право на свободу вираження) творець не притягується до відповідальності.

Також активно створюються програми, що можуть відрізнити підробку від оригіналу. Зокрема, цим займається один з лідерів ринку у сфері ПЗ «Adobe Systems».

Та, як відомо, вірус шириться швидше, аніж вигадують ліки чи вакцину від нього. Проведіть аналогію з пандемією коронавірусу. Чим досконалішими стають системи з виявлення фейків, тим скоріше мутують самі deep fake. Але… має ж бути рішення хоча б тимчасове? І воно є, ми можемо самостійно розпізнати глибинну підробку, маючи базові знання з теми, наприклад, ті, що ви тільки-но прочитали.

Підібрала для вас найдієвіші та найпростіші поради:

- стежте за мерехтінням облич;

- звертайте увагу на колір обличчя та тіла;

- шукайте першоджерело;

- зважайте на тривалість відео;

- фіксуйте увагу ще й на звук;

- сповільнюйте відео, щоб краще розглянути деталі;

- дивіться в рот😲 – нечітка внутрішня частина рота (зуби та язик) видають діп фейки;

- стежте за морганням.

Людству не втекти від штучного інтелекту. Триває активна дискусія про те, яким буде світ за 5, 10 років: прогнозів немає. Як запобігати можливим загрозам? Як правильно використовувати ці технології на благо людству? Чи реально «вживатися» з діп фейками? Поки чітких відповідей на ці питання не існує. Однак, відомо одне: люди мають знати про вплив штучного інтелекту на їхні права, на демократію, на медіа, про всі реальні та потенційні ризики використання діп фейків.

Авторка: Ліза Бровко

Попередні матеріали цієї авторки: